12:38 Как использовать файл robots.txt | |

В начале лета интернет-маркетологи отметили юбилей: файлу robots.txt исполнилось 20 лет. В честь этого Google расширил функциональность инструментов для веб-мастеров, добавив в набор средство проверки файла robots.txt. Опытные маркетологи прекрасно знают, что это за файл и как с ним работать. А начинающие специалисты получат базовую информацию из этой статьи.  Зачем необходим файл robots.txt

Зачем необходим файл robots.txt

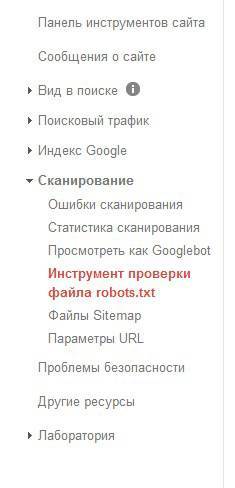

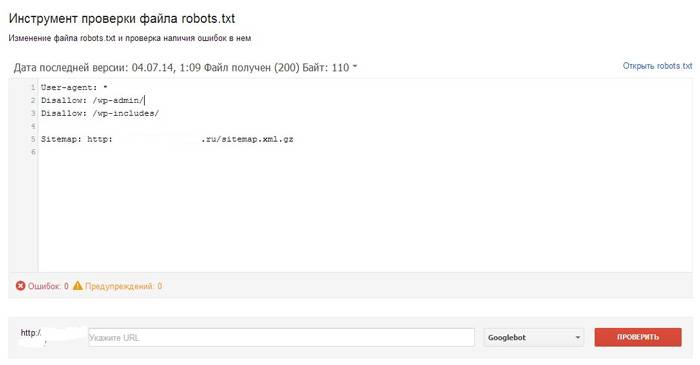

В файле robots.txt содержится информация, которую используют при сканировании сайта поисковые роботы. В частности, из robots.txt краулеры узнают, какие разделы сайта, типы страниц или конкретные страницы не следует сканировать. С помощью файла вы исключаете из индекса поисковых систем контент, который не хотите показывать поисковикам. Также вы можете запретить индексирование дублированного контента. Если вы используете robots.txt неправильно, это может стоить вам дорого. Ошибочный запрет на сканирование исключит из индекса важные разделы, страницы или даже весь контент целиком. В этом случае вам сложно рассчитывать на успешное продвижение сайта. Как работать с файлом robots.txtТекстовый файл robots.txt содержит инструкции для роботов поисковых системы. Обычно его используют для запрета сканирования служебных разделов сайта, дублированного контента или публикаций, которые не предназначены для всей аудитории. Если у вас нет необходимости закрывать от сканирования какой-либо контент вам можно не заполнять robots.txt. В этом случае запись в файле выглядит так: User-agent: * Disallow: Если вы по каким-то причинам собираетесь полностью заблокировать сайт для поисковых роботов, запись в файле будет выглядеть так: User-agent: * Disallow: / Чтобы правильно использовать robots.txt, вы должны иметь представление об уровнях директив: Помните о наиболее распространенных ошибках, встречающихся при составлении robots.txt: В этом случае директива выглядит так: User-agent: * Disallow: / Зачем создавать сайт, если вы не разрешаете поисковикам его сканировать? Использование этой директивы уместно на стадии разработки или глобального усовершенствования ресурса. Например, веб-мастер может запретить сканировать папки с видео и изображениями: Disallow: /images/ Disallow: /videos/ Сложно представить ситуацию в которой запрет на сканирование индексируемого контента был бы оправданным. Обычно такие действия лишают сайт части трафика. Это действие не имеет никакого смысла. Поисковые системы по умолчанию сканируют весь доступный контент. С помощью файла robots.txt можно запретить сканирование, однако разрешать что-либо индексировать не нужно. Инструмент проверки файла robots.txtВ середине июля Google представил инструмент проверки файла robots.txt, доступный в панели для веб-мастеров. Чтобы найти его, воспользуйтесь меню «Панель инструментов сайта – сканирование – инструмент проверки файла robots.txt».

Новый инструмент решает следующие задачи:

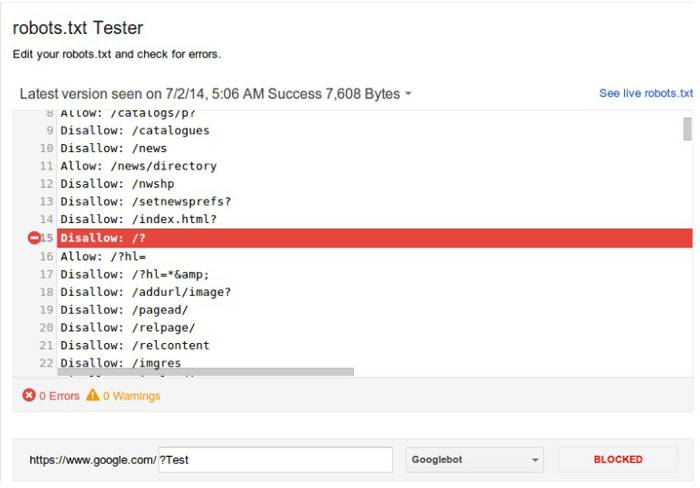

Если Google не индексирует отдельные страницы или целые разделы вашего сайта, новый инструмент поможет вам в течение нескольких секунд проверить, связано ли это с ошибками файла robots.txt. По данным эксперта Google Асафа Арнона, инструмент подсвечивает конкретную директиву, которая приводит к блокировке индексирования контента.

Вы можете внести изменения в robots.txt и проверить его корректность. Для этого достаточно указать интересующий вас URL и нажать кнопку «Проверить». Представитель Google Джон Миллер рекомендует всем владельцам сайтов проверить файл robots.txt с помощью нового инструмента. По мнению эксперта, потратив несколько секунд на проверку, веб-мастер может выявить критические ошибки, которые препятствуют краулерам Google. Чтобы правильно использовать…… файл robots.txt, необходимо понимать его практический смысл. Этот файл служит для ограничения доступа к сайту для поисковых систем. Если вы хотите запретить роботам сканировать страницу, раздел сайта или тип контента, внесите соответствующую директиву a robots.txt. Проверяйте корректность использования файла с помощью нового инструмента доступного в панели для веб-мастеров Google. Это поможет вам быстро обнаружить и устранить ошибки, а также внести в robots.txt необходимые изменения. Читайте также: | |

|

| |

| Всего комментариев: 0 | |